خلاصه

حتی با وجود RAG، مدلها ممکن است پاسخی بدهند که سند بازیابیشده آن را تأیید نکند. این مقاله نشان میدهد چهار نوع توهم RAG چیست و چطور با چارچوب دوستارهای «بازیابی درست» و «پاسخ وفادار» آن را در n8n اندازهگیری کنید.

مقدمه

شما فکر میکنید با متصل کردن اسناد شرکت به LLM دیگر خبری از اطلاعات اشتباه نیست؛ اما تجربه نشان میدهد مدل هنوز هم میتواند دلیلسازیهای بیپایه کند. بیایید ببینیم چرا این اتفاق میافتد و چطور آن را بسنجیم.

چهار نوع توهم در RAG

۱. تضاد آشکار

پاسخ مستقیماً با اطلاعات سند تناقض دارد؛ مثلاً عدد یا نام را اشتباه میگوید.

۲. تضاد پنهان

کلمهای جایگزین میشود که معنای کلی را عوض میکند؛ مثلاً «کاهش موقت» به «سقوط شدید» تبدیل میشود.

۳. افزودن بیمورد آشکار

مدل اطلاعاتی میسازد که در سند نیست؛ مثلاً دلیل افت درآمد را بلوک کانال سوئز مینامد درحالیکه سند چیزی درباره آن نگفته.

۴. افزودن بیمورد پنهان

با استنباط شخصی جمله را کامل میکند؛ مثلاً میگوید «احتمالاً مشتریان ناراضی بودهاند» بدون اینکه سند اشارهای به رضایت مشتری کرده باشد.

چارچوب دوستاره ارزیابی RAG

ستون اول: بازیابی درست (Document Relevance)

- فراخوانی زمینه (Context Recall): چند درصد اطلاعات مهم واقعاً آورده شده؟

- دقت زمینه (Context Precision): چند درصد چانکهای بازیابیشده به سؤال مربوطاند؟

هر دو معیار را میتوان با قاضی-LLM یا بدون LLM (شباهت معنایی، Levenshtein) محاسبه کرد.

ستون دوم: پاسخ وفادار (Groundedness)

- Faithfulness: آیا هر ادعای پاسخ در اسناد آمده؟ مدل متنساختار RAG را با دانش پیشآموزش خود قاطی نکند.

- Response Relevancy: پاسخ چقدر سرراست به سؤال میپردازد؟ بیربط یا اضافه نیست؟

ارزیابی در n8w بدون کدنویسی

گام ۱: مجموعه تست آماده کنید

چند سؤال واقعی همراه پاسخ طلایی بنویسید و ذخیره کنید.

گام ۲: workflow ارزیابی را اجرا کنید

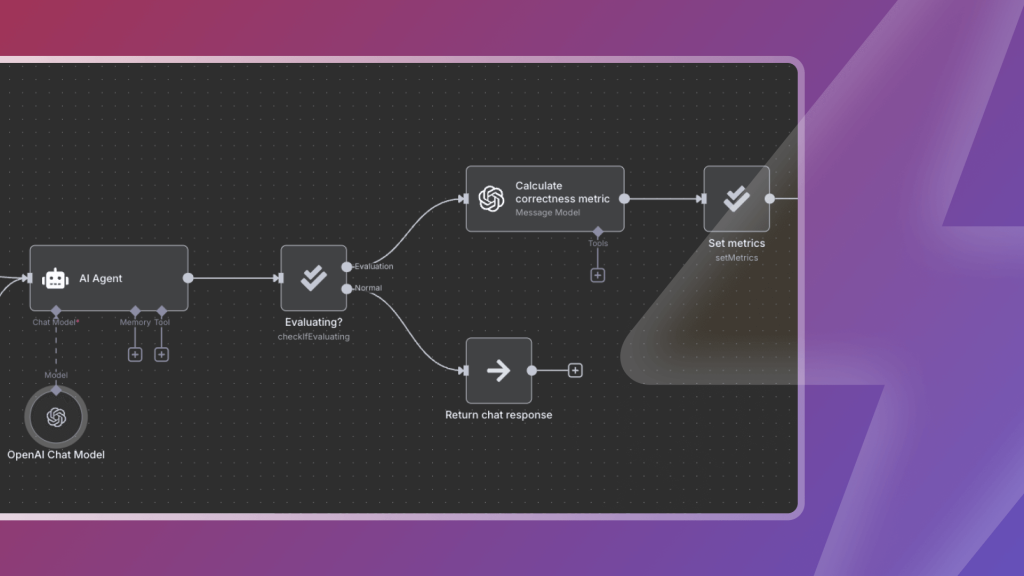

در n8n دو تمپلیت آماده است:

- Evaluate RAG Response Accuracy: وفاداری پاسخ را با LLM میسنجد.

- RAG Document Relevance: فراخوانی و دقت بازیابی را محاسبه میکند.

گام ۳: نتایج را مقایسه کنید

هر اجرا نمرهای ارائه میدهد؛ با تغییر پرامپت یا پارامترهای بازیابی ببینید چهقدر بالا یا پایین میرود.

چکلیست سریع بهینهسازی RAG

- چانکبندی کوچک و همپوشان کمتر → نویز کمتر

- بازیابی ترکیبی (ترکیب keyword + semantic) → یادآوری بالاتر

- پرامپت ساده با دستور «فقط از اسناد پاسخ بده» → وفاداری بیشتر

- هر بار تغییر دادید، همان مجموعه تست را دوباره اندازهبگیرید → پیشرفت را ببینید